Un enfoque horizontal: cómo destacar en la fase global

Al elaborar su enfoque en torno a la legislación sobre inteligencia artificial (IA), la UE ha optado por un marco legislativo de carácter horizontal. En este respecto, el marco jurídico sobre IA de la UE adopta una perspectiva independiente del sector y se ha diseñado de manera meticulosa a partir de casi cien artículos.

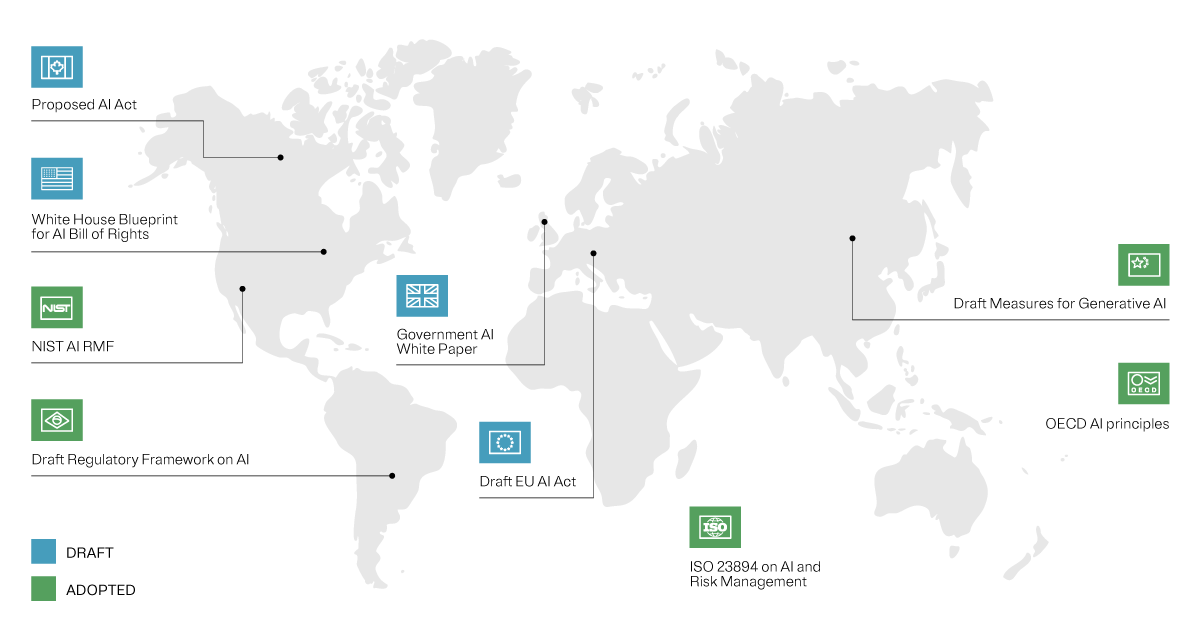

En esta publicación, intentaremos analizar la Ley de IA de la UE. Esta legislación no es solo la primera de su tipo, sino también un punto de referencia para la regulación de la IA a nivel global, puesto que se ha desarrollado para ayudar a crear un precedente en el panorama de la IA en tan rápida evolución.

Garantía de valores e innovación

La Ley de IA de la UE está bien equilibrada. No se trata únicamente de colocar un colchón de seguridad para la sociedad, la economía, los derechos fundamentales y los valores esenciales de la UE, que podrían verse en riesgo a raíz de los sistemas de IA. También es un nexo para el afianzamiento y el potencial de la innovación de la IA, con garantías prediseñadas que tienen el fin de promover y proteger los novedosos avances de la IA. Además, se intenta buscar el equilibrio entre la gestión de riesgos y la protección de infraestructura crítica frente a perjuicios potenciales, a la vez que se promueve la innovación que la IA en general puede traer consigo.

Elaborar la Ley de IA de la UE ha sido todo menos sencillo. De hecho, definir la IA fue uno de los puntos más complicados. Desde su propuesta inicial en abril de 2021, esta ley ha sido un documento vivo. A través de sus numerosas iteraciones, cada enmienda refleja un discurso fluido sobre la tecnología de IA y sus implicaciones para la sociedad.

En una reunión, Francia, Alemania e Italia plantearon sus preocupaciones sobre las limitaciones impuestas a los potentes modelos de IA y quisieron adoptar un régimen normativo menos estricto para modelos como el GPT-4 de OpenAI.

Tras un debate continuo, el compromiso alcanzado por la Comisión Europea fue adoptar un enfoque escalonado, con normas de transparencia horizontal para todos los modelos y obligaciones adicionales para los modelos convincentes con riesgo sistémico.

En qué punto se encuentra esta ley

El 2 de febrero de 2024, el Comité de Representantes Permanentes votó a favor del acuerdo político que se alcanzó en diciembre de 2023. Por su parte, el 13 de marzo, el parlamento votó a favor de esta ley, con 523 votos a favor, 46 en contra y 49 abstenciones.

Por tanto, la Ley de IA entrará en vigor 20 días después de su publicación en el Boletín Oficial de la UE. Las disposiciones sobre sistemas prohibidos se aplicarán después de 6 meses y las obligaciones para proveedores de IA de uso general se aplicarán después de 12 meses. La mayoría del resto de requisitos se aplicarán después de dos años.

Dicho esto, los sistemas de alto riesgo que estén destinados a utilizarse como componente de seguridad de un producto o estén cubiertos por otras leyes de la UE tendrán un plazo de 36 meses para cumplir con la Ley de IA de la UE.

IA: desglosando el concepto

En principio, la ley definió el aprendizaje automático, es decir, los fundamentos de los sistemas de IA, como «el aprendizaje de refuerzo supervisado o no que utiliza una amplia variedad de métodos, entre los que se incluye el aprendizaje profundo». El texto incluye una definición actualizada que define a los sistemas de IA como «un sistema basado en máquinas que está diseñado para funcionar con diversos niveles de autonomía y que puede mostrar capacidad de adaptación tras su despliegue, y que, para objetivos explícitos o implícitos, infiere, a partir de la entrada que recibe, cómo generar salidas tales como predicciones, contenidos, recomendaciones o decisiones que pueden influir en entornos físicos o virtuales».

Dicho esto, la complejidad de los sistemas de IA es como una escala móvil, con sistemas más complejos que requieren una potencia informática sustancial y datos de entrada. El resultado de estos sistemas puede ser simple o muy complejo, lo que varía según la sofisticación de la IA en concreto.

Esta amplia definición abarca una gama de tecnologías, desde chatbots hasta modelos de IA generativos altamente sofisticados. Sin embargo, es importante tener en cuenta que no se regularán todos los sistemas de IA dentro de esta amplia definición de la ley. La ley establece un marco inteligente de acuerdo con un enfoque basado en riesgos, lo que hace que caigan sobre su paragüas regulatorio solo aquellos sistemas que estén asociados con niveles de riesgos específicos calibrando según el riesgo

Regulación de la IA: calibrando según el riesgo

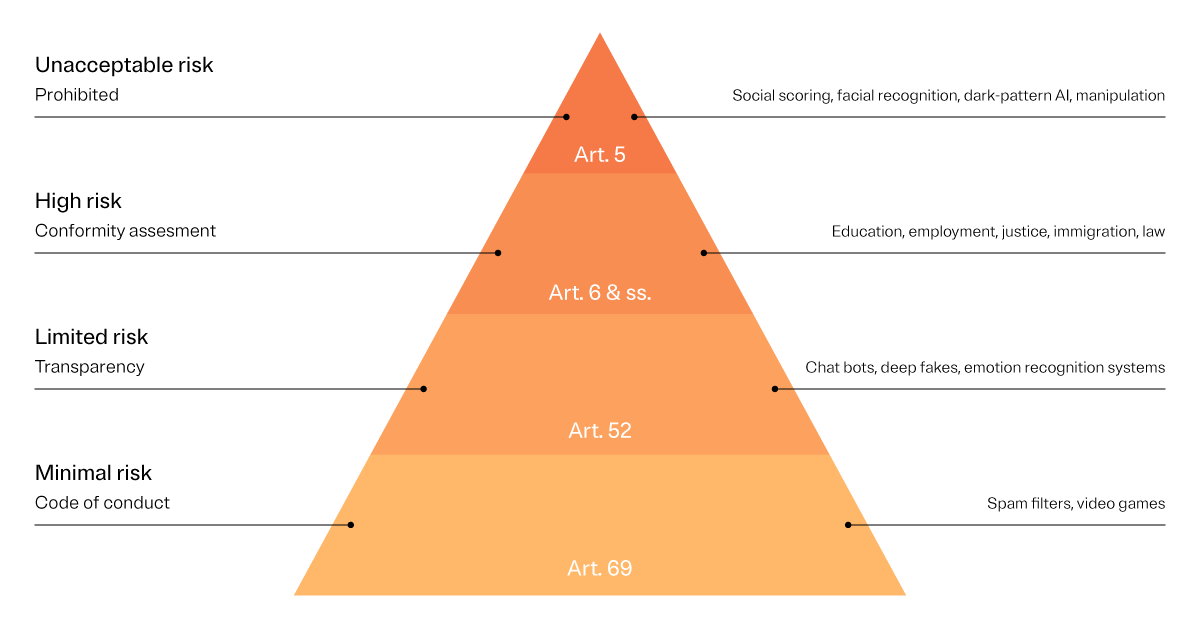

Aquí es donde la cosa se pone interesante. La Ley de IA de la UE tiene diferentes categorías para los sistemas de IA. Y se considera que algunas de estas categorías suponen un riesgo inaceptable para los valores de la UE, lo que desemboca en su prohibición. Los sistemas de riesgo elevado, aunque no están prohibidos per se, tienen que ajustarse a una normativa más estricta. Es vital recordar que estas categorías de riesgo no son estáticas; de hecho, la ley aún se encuentra en borrador y, a medida que se vayan produciendo más cambios, estas categorías de riesgo probablemente también acabarán ajustándose.

Niveles de riesgo según la Ley de IA de la UE

La Ley de IA de la UE define múltiples niveles de riesgo permisible: elevado, limitado y mínimo.

Estos son los niveles de riesgo permisible para las organizaciones, aunque también está el riesgo inaceptable que es otro nivel pero que no está permitido, puesto que si se llega a este punto los modelos de la empresa deben cambiarse de la manera más adecuada.